Компанія Nvidia оприлюднила результати тестування свого найновішого сервера для штучного інтелекту, який демонструє десятикратне прискорення роботи сучасних ШІ-моделей. Про це повідомляє Reuters.

Зміщення уваги індустрії від навчання моделей — де Nvidia є безперечним лідером — до їх масштабного використання мільйонами користувачів посилює конкуренцію з боку AMD та Cerebras. Тому компанія прагне довести ефективність своїх рішень не лише в тренуванні, а й у виконанні моделей у реальному часі.

У центрі уваги — моделі типу “суміш експертів” (Mixture of Experts, MoE). Такий підхід став популярним після прориву китайської DeepSeek, яка створила продуктивну відкриту модель, що використовувала значно менше ресурсів Nvidia під час навчання. Згодом методологію MoE взяли на озброєння OpenAI, Mistral і китайська Moonshot AI.

- Читайте також: Nvidia інвестує рекордні $100 млрд у дата-центри OpenAI для розвитку штучного інтелекту

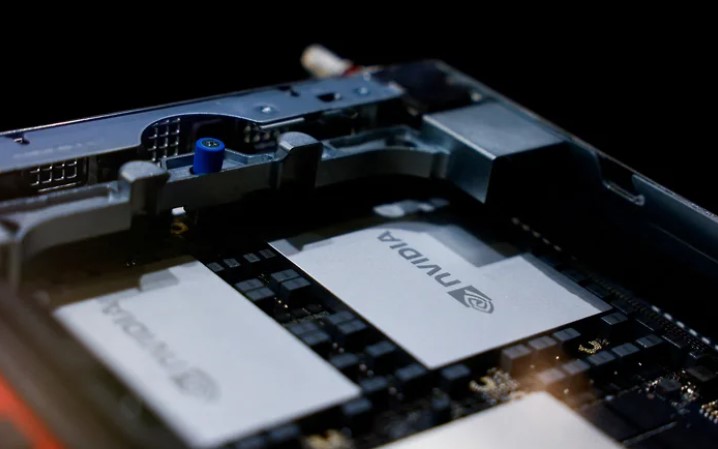

У відповідь Nvidia продемонструвала, що її новий AI-сервер, який поєднує 72 передові GPU у єдину систему зі швидкісними внутрішніми з’єднаннями, здатен у 10 разів прискорити роботу моделі Kimi K2 Thinking від Moonshot у порівнянні з попереднім поколінням серверів. Аналогічний приріст зафіксовано і для моделей DeepSeek.

У Nvidia пояснюють, що головна причина такого стрибка — можливість розміщувати значно більше чипів у одному сервері та забезпечувати між ними надшвидкі зв’язки — технологію, у якій компанія все ще має перевагу над конкурентами.

Тим часом AMD також працює над власним серверним рішенням із мультичиповою архітектурою, яке очікується на ринку вже наступного року.